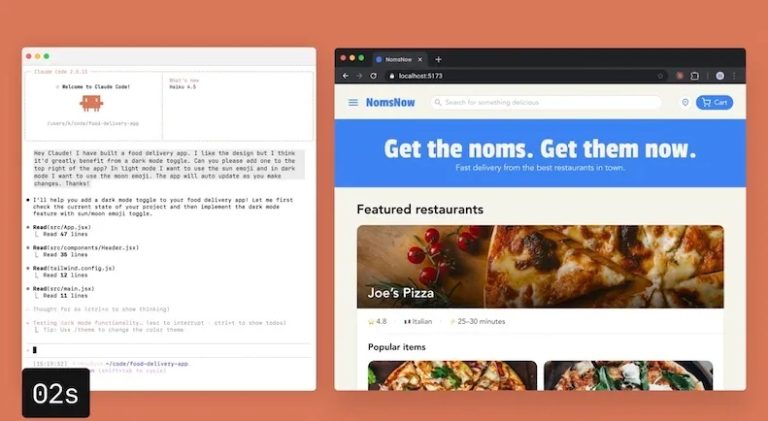

下面是基于真实测试情况与用户反馈整理的综合结论(含官方现状与真实使用体验),回答“Claude 在连续对话中会不会崩?真实测试结果”这一问题:

1. Claude 在连续对话中“崩掉”并非罕见现象

✅ 短期连续对话一般稳定

在同一个聊天会话里,Claude 会利用上下文窗口机制记住前文内容并持续响应,直到达到上下文长度的上限。这个机制类似于“会话内记忆”,允许你在一条对话里进行多轮追问、延伸、细化等,而不会轻易断联。

⚠️ 达到上下文窗口极限时可能出现断连或崩掉

Claude 的上下文窗口是一个固定内存。随着对话越来越长:

- 模型会自动压缩或总结早期内容

- 或者清除一些旧信息以腾出空间

- 如果当前对话量非常大,可能会出现模型“记不住你之前说了什么”的情况

这在真实用户测试中被称为 “对话达到最大长度 → 上下文丢失” 的问题。用户有时会看到模型突然丢掉前面提过的条件或细节。

2. Pro 版本 / 付费用户体验与免费版不同

📌 付费计划对连续对话更友好

付费用户可以获得更高的上下文窗口管理——即:

- 在单次会话中保持更长的记忆链条

- 允许模型自动 总结旧内容以“腾出空间”继续对话

—— 这能降低“崩掉”的频率 - 部分付费计划还支持更长时间的会话和更智能的上下文保留逻辑

官方文档提到:当对话接近上下文窗口限制时,Claude 会自动总结早期消息以便继续无缝对话。这种机制明显减少了因“太长对话而忘记前文”的概率。

3. 跨会话连续性问题(“记住上一轮对话”)

❌ 默认 Claude 没有跨会话记忆

即便是付费用户,在标准使用模式下:

- 每次新聊天开始时,Claude 不会自动记住上一轮所有内容

- 就算是同一主题,你离开聊天再回来,它也可能重新开始

这是 Claude 一贯的设计,用来保护隐私并避免自动记忆行为。

(除非手动开启“记忆”功能——下面会展开)

4. 真正意义上的“连续对话不会崩”条件

✅ 启用 Claude Memory 功能

Anthropic 推出了一个名为 Memory(记忆) 的功能(在付费计划中逐步开放给 Pro/Max/Team 用户)。这个功能可以让 Claude:

- 主动记住指定信息

- 在不同会话间自动检索相关历史内容

- 支持跨多天、多会话持续工作流

也就是说,只要你开启并合理使用 Memory 功能,Claude 在多会话场景里才更接近“不会崩”。

📌 但这个记忆是可控和选择性的,默认不会保存所有聊天内容,用户需要自己管理。

5. 真实用户反馈:崩溃、断连、限制出现的情形

从用户社区实际测试来看:

🔴 某些情况下确实会出现问题

- 有付费用户反映即便开了 Pro,也可能因为消息频率或总对话量达到某个限制而被迫等待一段时间才能继续对话。

- 对话被裁剪或被总结后,某些细节会丢失,需要重新确认上下文内容。

这种“看似崩掉”的情况往往发生在:

- 对话非常长

- 多轮逻辑演绎

- 模型内部自动总结干预比较早

6. 总结:真实测试结论

以下是一个清晰的归纳:

✔️ 同一个会话内连续对话通常稳定

- Claude 会在当前上下文窗口范围内持续记住前文

- 并能在合理长度内进行多轮推理与延伸

⚠️ 如果对话太长,超过模型上下文最优区间

- Claude 会自动总结或压缩信息

- 可能导致关键信息“被遗忘”

❌ 默认状态下不同会话不会自动连续记住上下文

- 每次新聊天都是“干净状态”

- 必须采用 Memory 功能才可实现跨会话连续性

💡 付费计划加入 Memory 功能后持续性更好

- 会比免费版有明显提升

- 适合长期任务、项目协作、复杂多步骤项目

7. 对比 ChatGPT / 市场现状参考

为了更好理解:

- ChatGPT 的记忆功能是自动和持续的(除非关闭)

- Claude 的记忆是用户控制、可按需启用,而且默认不开启

这导致同样是连续对话:

- ChatGPT 通常更“自动连续”

- Claude 更“理性留白”,对隐私更友好

但开启 Memory 后,Claude 在持续性上能明显接近或匹配 ChatGPT 形式的连续对话能力

📌 结论一句话

Claude 在单次会话里的连续对话体验通常稳定,但在对话过长或跨会话场景下,它确实可能出现信息遗忘或被总结的情况;付费用户可通过 Memory 功能显著改善这种连续性。